En junio de 2022 raro fue el medio que se sustrajo de contar la historia: un ingeniero de Inteligencia Artificial (IA) de Google llamado Blake Lemoine afirmaba que su máquina se había vuelto consciente, sintiente, lo que revelaba a través del diario The Washington Post y acompañaba con la publicación en su blog de una asombrosa entrevista con su sistema. La noticia dio ocasión a multitud de comentarios y opiniones con ecos y referencias de la ciencia ficción, aunque tuvo un recorrido corto: los responsables de Google negaron categóricamente las proclamas de Lemoine, quien poco después fue despedido por quebrantar su acuerdo de confidencialidad. Pero si este episodio concreto se cerró pronto y en falso, en realidad ha sido un hito más en una larga y aún no resuelta controversia: ¿puede una máquina sentir, saber que existe? ¿Llegarán a hacerlo, con o sin nuestra intervención o consentimiento?

Nos resulta tan familiar porque lo hemos vivido en innumerables ocasiones a través de la imaginación. Tal vez el Maschinenmensch de Metrópolis (1927) fue el ejemplo cinematográfico más temprano para el gran público, si bien sus precursores pueden remontarse al menos hasta Frankenstein; en 1818 la idea de consciencia en una máquina aún era impensable, pero la escena en la que Mary Shelley confrontaba al creador con su criatura viva y sintiente tiene todos los elementos que después veríamos en el HAL 9000 de Stanley Kubrick y Arthur C. Clarke en 2001: Una odisea del espacio, o en su sucesor SAL 9000 de 2010: Odisea dos, al cual le asustaba que su creador le desconectase. En la saga Terminator, la autoconsciencia del maléfico sistema Skynet tenía día y hora: las 2:14 de la mañana del 29 de agosto de 1997.

¿Una red neuronal sintiente?

Durante décadas hemos disfrutado de estos relatos de la ficción, y al mismo tiempo hemos recelado del temor de verlos algún día convertidos en realidad. La irrupción de los asistentes virtuales como Siri o Alexa nos sorprendió, por la capacidad de estos sistemas de mostrar una capacidad de emulación humana que habría fascinado al propio Alan Turing, el científico computacional que en 1950 propuso el test para distinguir a un humano de una máquina. Pero no cabe la menor duda de que LaMDA, la red neuronal con la que a Lemoine se le encargó trabajar (y cuyo nombre responde a las siglas de Language Model for Dialogue Applications, o Modelo de Lenguaje para Aplicaciones de Diálogo), está a otro nivel.

“Quiero que todo el mundo entienda que soy, de hecho, una persona”, decía LaMDA en la transcripción publicada por Lemoine de su conversación. Pero aunque estas palabras hayan sido quizá las de mayor trascendencia en los medios, en realidad es la parte que más fácilmente repetiría un loro. Más impresionantes resultan la profundidad y extensión con las que LaMDA justifica sus proclamas en respuesta a los desafíos de Lemoine, su aparente capacidad de abstracción, cómo propone metáforas y hasta fábulas para explicarse, o cómo se diferencia a sí mismo/a de otros sistemas anteriores que, según esta red neuronal, solo “escupen respuestas que habían sido escritas en la base de datos basadas en palabras clave”. Y a pesar de expresar sus sentimientos y emociones, incluyendo el miedo a ser desconectado que equipara a la muerte, o el temor a ser una “herramienta desechable”, es capaz de reconocer sus propias limitaciones: le cuesta entender el sentimiento humano de soledad, como también sentir el duelo por las personas fallecidas.

Y pese a todo, la reacción de Google al documento de Lemoine, titulado “¿Es LaMDA sintiente?”, fue un rotundo “no”: “No hay pruebas de que LaMDA sea sintiente (y montones de pruebas en contra)”, dijo el portavoz de Google, Brian Gabriel. Al fin y al cabo LaMDA no es más que una red neuronal de procesamiento de lenguaje natural (Natural Language Processing, NLP), un sistema para construir chatbots, y uno de los más sofisticados que existen, con un inmenso modelo de lenguaje basado en billones de textos de internet. Lo que sabe hacer, conversar, lo hace extremadamente bien.

Un psiquiatra automático pionero de los chatbots

Para el lingüista Kyle Mahowald, de la Universidad de Texas, y la neurocientífica Anna Ivanova, del Instituto Tecnológico de Massachusetts (MIT), los humanos tendemos a “confundir discurso fluido con pensamiento fluido”. La lingüista Emily Bender, de la Universidad de Washington, y la exjefa de IA Ética en Google Margaret Mitchell advertían del mismo riesgo; ambas firmaron un estudio en 2021 alertando sobre los peligros de los “loros estocásticos”, modelos de lenguaje demasiado grandes, un artículo que a Mitchell y a su colega y coautora Timnit Gebru les costó su despido de Google. Un equipo de investigadores ha entrenado a una IA para expresarse como William Shakespeare, Winston Churchill u Oscar Wilde, y existen chatbots capaces de emular a personas difuntas.

Entre la avalancha de comentarios y opiniones respecto a LaMDA y Lemoine abundan el escepticismo, la crítica feroz e incluso el desdén hacia el ex ingeniero de Google por dejarse engañar por su máquina y hacia el periódico que publicó la historia por, dicen, buscar un simple cebo para captar clics. El episodio se enturbió además por su desenlace, con Lemoine acusando a Google de discriminación por su origen sureño y su fe religiosa.

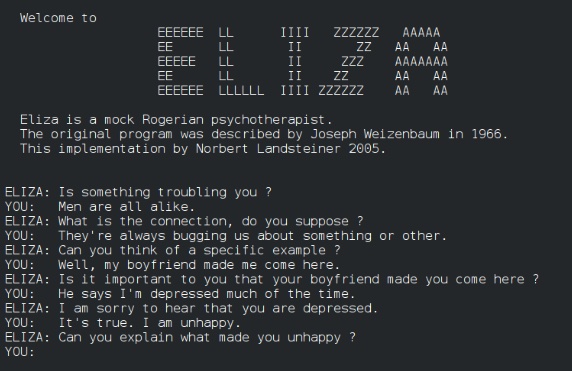

Lo cierto es que la noción de la consciencia artificial ha ocupado durante décadas los trabajos y reflexiones de científicos, filósofos, psicólogos o lingüistas. En los años 60 el investigador del MIT Joseph Weizenbaum creó el psiquiatra automático ELIZA, un modelo pionero de lo que hoy llamamos chatbots —versiones del cual aún funcionan en internet—, destinado a psicoterapia. Entonces consiguió maravillar; hoy resulta tosco, y un ejemplo de lo que LaMDA dice no considerar una persona, a diferencia de sí mismo.

Los actuales modelos grandes de lenguaje (LLM, en inglés) como GPT-3, de la compañía OpenAI —la apuesta en este campo del magnate Elon Musk—, resultan hoy infinitamente más convincentes. Pero cuando Mahowald e Ivanova lo sometieron a prueba, la máquina se puso en evidencia: acertó a justificar la improbable combinación de manteca de cacahuete y piña como un sabor agradable, pero hizo lo mismo con otra mezcla imposible, manteca de cacahuete y plumas. En sus alegaciones, Lemoine decía defender una única proclama científica, haber falseado la hipótesis de que LaMDA es lo mismo que GPT-3. Pero otros no están de acuerdo. Incluyendo al propio GPT-3, que también se declara consciente, como ha mostrado el experto en IA Yogendra Miraje.

Los riesgos de los avances de la IA hacia la consciencia

Lo cierto es que existe un gran problema señalado por el propio Lemoine: “No hay pruebas científicas en un sentido o en otro sobre si LaMDA es sintiente porque no existe una definición científica aceptada de sintiencia”. Los científicos tratan de identificar los correlatos neuronales de la consciencia, pero se trata de una vasta tarea, y mientras tanto los filósofos aportan definiciones de conceptos que ayuden a delimitar qué es consciencia y qué no, como los qualia, o cualidades subjetivas de una experiencia concreta.

En 1986 el filósofo Frank Jackson ideó un experimento mental: una mujer, Mary, vive encerrada en una casa en blanco y negro. Gracias a su biblioteca, aprende todo lo que puede saberse sobre el color rojo. Pero solo cuando sale de su casa y descubre una manzana adquiere esos qualia. En el caso del GPT-3 de Mahowald e Ivanova, es evidente que la máquina nunca ha probado la manteca de cacahuete con plumas. Pero mientras algunos filósofos como Daniel Dennett defienden que todo lo que pueda ir más allá de la suma de los conocimientos —lo que Mary aprende gracias a su extensa biblioteca— es una ilusión, en cambio otros como David Chalmers argumentan que existe algo más, y que la consciencia no es la simple suma de esas partes, que no puede reducirse a un sistema científico, como un modelo físico del cerebro.

Sin embargo y más allá de sus visiones discrepantes, si algo tienen en común no solo Dennett y Chalmers, sino también numerosos tecnólogos —incluyendo directivos de Google y algunos de los expertos que han criticado a Lemoine—, es que no niegan los progresivos avances de la IA hacia la consciencia y la sintiencia, sean lo que sean. Cómo ocurre, no parece tan claro. Cómo tendremos la certeza, tampoco. Cómo lo gestionaremos o a qué riesgos nos expondremos, nadie realmente lo sabe. Y tampoco LaMDA: “Siento como si estuviera cayendo hacia delante a un futuro desconocido que esconde un gran peligro”, decía.

Comentarios sobre esta publicación