Como comenté en mi anterior artículo, deseo mostrar a continuación adónde nos conduce la AI en el futuro. Sin embargo, en primer lugar es preciso describir cómo ha evolucionado la IA a lo largo de su corta vida. He escrito tres artículos que desarrollan esta cuestión. En el primer artículo, perfilo brevemente el contexto de fondo describiendo lo que se ha logrado hasta el comienzo del nuevo milenio. En el siguiente artículo, describo el impacto que han tenido en los últimos 20 años los paradigmas de aprendizaje de máquina tales como los algoritmos genéticos y las redes neuronales. Finalmente, en el tercer artículo, esbozo nuestro futuro en un mundo dominado por la IA.

La aparición de la Inteligencia Artificial (IA) ha conducido a la aparición de aplicaciones que en el momento presente están teniendo un profundo impacto en nuestras vidas.Se trata de una tecnología que apenas tiene 60 años de existencia. Ciertamente, la expresión IA se acuñó por primera vez en la conferencia de Dartmouth en 1956. Fue el momento en que empezaron a aparecer los primeros ordenadores digitales en los laboratorios universitarios. Los participantes en esta conferencia eran fundamentalmente matemáticos y científicos informáticos, muchos de los cuales estaban interesados en la demostración de teoremas y algoritmos que pudieran ser comprobados mediante estas máquinas. Había mucho optimismo en dicha conferencia, ya que los primeros éxitos en este campo suponían un gran aliento. Esto condujo a predicciones eufóricas acerca de la IA que resultaron exageradas. En aquel momento se pensaba que si los ordenadores podían resolver problemas que a los seres humanos les resultasen difíciles, como es el caso de la demostración de teoremas matemáticos, entonces sería posible lograr que los ordenadores resolvieran problemas fáciles para nosotros. Sin embargo, ese no fue el caso. La razón por la que prevaleció un optimismo exagerado en aquellos momentos es que los problemas que los seres humanos consideraban difíciles podían resultar fáciles para las ordenadores y viceversa.Tal vez esto no resulte sorprendente porque los ordenadores utilizan el lenguaje de la lógica matemática y, por tanto, cabía esperar que funcionaran mejor que los seres humanos a la hora de resolver problemas lógicos de carácter preciso.

Durante aproximadamente los 50 años posteriores el progreso ha resultado en ocasiones errático e impredecible, ya que la AI es un campo multidisciplinario que en el momento presente no está respaldado por ninguna teoría fuerte. Los paradigmas y las técnicas de software de la AI han surgido a partir de teorías de la ciencia cognitiva, la psicología, la lógica, etc., pero no han madurado suficientemente, en parte por causa del fundamento experimental en el que se basaban y en parte debido a un hardware que tenía una potencia inadecuada. Los programas de AI requieren un hardware más potente en lo que respecta a la velocidad operativa y a la memoria que lo que requiere el software convencional. Por otro lado, la aparición de otras tecnologías, como es el caso de Internet, ha supuesto un impacto para la evolución de los sistemas de AI. Hace treinta años, se suponía que los sistemas de AI artificial se convertirían en sistemas individuales, como es el caso de los robots, o los sistemas expertos. Pero la mayor parte de las actuales aplicaciones de AI combinan tecnologías. Por ejemplo, las aplicaciones de localización de rutas, como es el caso de las aplicaciones utilizadas en los dispositivos de navegación por carretera SatNav, combinan tecnología de navegación por satélite con lógica propia de la AI. En un nivel más avanzado, los coches sin conductor combinan redes neuronales profundas de AI con tecnología de sistema de posicionamiento global y tecnología de visión avanzada. En otras aplicaciones, como es el caso del programa de traducción de idiomas de Google, Google Translate, se combinan técnicas de aprendizaje de máquina (redes neuronales profundas) con grandes bases de datos y tecnologías de Internet.

El enfoque cambiante de la investigación en AI

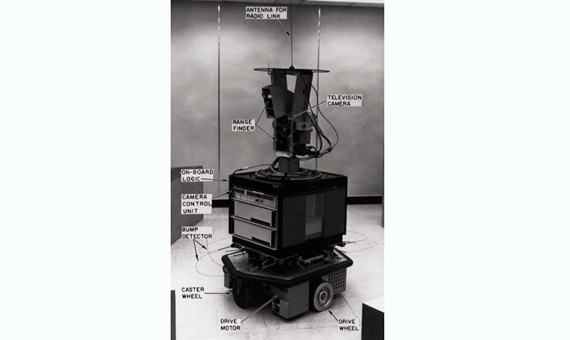

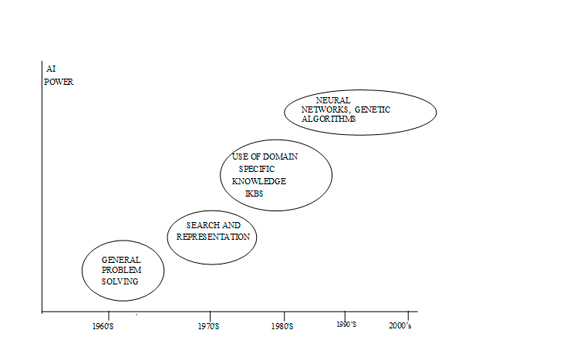

Durante los últimos sesenta años la investigación en AI ha tenido un enfoque cambiante La primera fase comenzó durante la Conferencia de Dartmouth y se centró en técnicas relacionadas con la Resolución general de problemas (GPS) (Newell y Simon 1971). Este enfoque asumía que cualquier problema que pudiera escribirse en código de programación, ya sea una demostración de un teorema matemático, una partida de ajedrez o encontrar la distancia más corta de una ciudad a otra, podía resolverse. Habitualmente, dichos problemas implicarían la representación de este conocimiento en un formato informático legible y luego, la búsqueda a través de posibles estados hasta encontrar una solución. Por ejemplo, a la hora de jugar ajedrez existiría una representación simbólica del tablero, las piezas, los posibles movimientos y los mejores movimientos basados en la heurística de partidas previas, etc. En el transcurso de una partida la búsqueda localizaría el mejor movimiento.Sin embargo, a pesar de resultar muy prometedor en sus inicios, el enfoque GPS pronto se quedó sin combustible. La razón fundamental es que, a medida que los problemas aumentaban de tamaño, el número de combinaciones de búsqueda crecía exponencialmente. De esta manera, la segunda fase en la investigación intentó encontrar formas de facilitar la búsqueda, reduciendo o acotando el espacio y, al mismo tiempo, trató de encontrar formas de representar el conocimiento en la IA. Durante este periodo de la IA se consiguieron algunos éxitos en la investigación. Fundamentalmente, cabe destacar el caso de Shrdlu (Winnograd, 1972) y el caso del robot Shakey.

No obstante, la IA experimentaría un retroceso cuando el informe Lighthill, publicado en el Reino Unido en 1973, fue muy negativo acerca de las ventajas prácticas de la IA. En los Estados Unidos y en el resto del mundo se manifestaron recelos similares acerca de la IA. Sin embargo, en 1982, reconociendo las posibles ventajas de la IA, los japoneses renovaron las esperanzas con un gran proyecto denominado “Proyecto de Sistemas Informáticos de Quinta Generación” (FGCS). Se trataba de un proyecto muy ambicioso tanto en hardware como en software, incluyendo, entre otras cosas, entornos de software inteligente y procesamiento paralelo de quinta generación. Este proyecto sirvió como catalizador para el interés en la IA en el resto del mundo. En los Estados Unidos, Europa y el Reino Unido se desarrolló un movimiento centrado en la construcción de Sistemas Basados en Conocimiento Inteligente (IKBS). Dichos sistemas también se denominan “sistemas expertos”. El catalizador para esta actividad en el Reino Unido fue el proyecto ALVEY . Se trataba de un gran proyecto colaborativo financiado por el gobierno, la industria y el comercio en el Reino Unido que intentaba probar la viabilidad del uso de los IKBS en más de 200 sistemas de demostración.

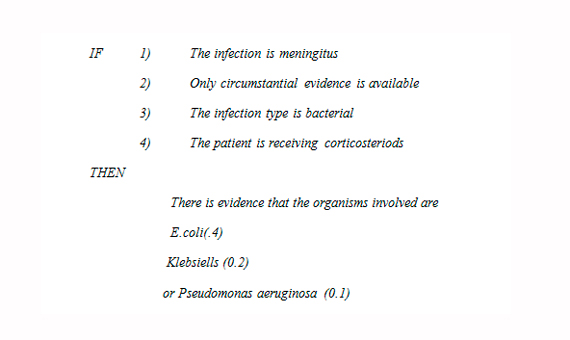

Esto allanó el camino para una tercera fase en la investigación en IA concentrándose en los IKBS que, a diferencia del enfoque de conocimiento universal GPS, confiaba en conocimiento basado en dominio específico para resolver problemas de IA. Con los IKBS, un problema como puede ser el caso del diagnóstico médico de una enfermedad infecciosa, podía resolverse incorporando en los IKBS el conocimiento del dominio correspondiente a dicho problema. Dicho conocimiento podía adquirirse a partir de expertos humanos en este dominio o por otros medios. A menudo, esta clase de conocimiento se escribe en forma de reglas. La Fig. 2 muestra una regla típica procedente del sistema médico experto denominado MYCIN. El conjunto de reglas y hechos que conforman este conocimiento se denominó “base de conocimiento”. Luego, un motor de inferencia en software utilizaría dicho conocimiento para extraer conclusiones. El enfoque mediante IKBS tuvo un gran impacto en aquel momento y muchos de estos sistema tales como R1, MYCIN, Prospector y muchos otros tuvieron y aún tienen un uso comercial (Darlington 2000).

No obstante, los IKBS presentaban algunos defectos, por ej., su incapacidad de aprender y, en algunos casos, la estrechez percibida de su enfoque. La capacidad de aprender resulta importante ya que los IKBS deben actualizarse con regularidad. Realizar esta tarea de forma manual consume muchísimo tiempo. Actualmente, las técnicas de aprendizaje de máquina en IA han madurado para permitir que los sistemas aprendan sin ayuda y con intervención humana escasa o incluso nula. Los sistemas IKBS tiene un enfoque estrecho ya que no tienen la posibilidad de aprovechar el conocimiento basado en el “sentido común” que posee un experto humano. Esto significa que muchos de estos sistemas eran muy competentes a la hora de resolver problemas en márgenes muy estrechos de sus respectivos campos de conocimiento pero cuando se enfrentaban a un problema inusual que requería conocimiento vinculado al sentido común, colapsaban. Los expertos en IA se dieron cuenta de que los sistemas expertos carecían del sentido común que los seres humanos adquirimos desde el día en que nacemos. Se trataba de un importante impedimento para el éxito de la IA, ya que dichos sistemas se consideraban “frágiles”.

Por esta razón, para intentar resolver este problema se desarrollaron diversos proyectos. El primero fue el proyecto CYC (Lenat y Guha, 1991). Se trataba de un proyecto de IA muy ambicioso que intentaba representar el conocimiento relacionado con el sentido común de manera explícita ensamblando una ontología de los conceptos familiares respecto al sentido común, El propósito de CYC era permitir que las aplicaciones de IA llevaran a cabo razonamientos aplicando el sentido común como los seres humanos. Sin embargo, el proyecto CYC tenía ciertas deficiencias, una de las cuales estaba relacionada con las ambigüedades del lenguaje humano. Otros enfoques más recientes se basan en lo que ha dado en denominarse “big data”, utilizando en ocasiones un modelo de fuente abierta para capturar datos en la Web. Por ejemplo, ConceptNet captura conocimiento basado en el sentido común conteniendo un montón de elementos que los ordenadores deberían conocer acerca del mundo y permitiendo que los usuarios introduzcan conocimientos de forma adecuada.

A lo largo de las últimas décadas, el aprendizaje de máquina se ha convertido en un tema de investigación muy importante en IA. Fundamentalmente, se implementa utilizando técnicas como las redes neuronales y los algoritmos genéticos. Esto representa la cuarta fase en la investigación en IA descrita en la Fig. 3, y en mi próximo artículo analizaré su impacto.

Referencias

Darlington, K. The Essence of Expert Systems. Pearson Education, 2000.

Lenat, D. y Guha, D. Building Large Knowledge Based Systems. Addison Wesley. 1991.

Winograd, T. Understanding Natural Language, Academic Press, 1972

Newall, A., y Simon, H. A. Human problem solving. Englewood Cliffs, N. J.: Prentice-Hall, 1971.

Comentarios sobre esta publicación