El Internet de las cosas (IdC) es un ecosistema cada vez más complejo; es la siguiente oleada de innovación que humanizará todos los objetos de nuestra vida. El IdC está incorporando cada vez más dispositivos (cosas) al mundo digital, por lo que en un futuro cercano probablemente se convertirá en un sector que mueva billones de dólares. Para entender el grado de interés que despierta el Internet de las cosas (IdC), no hay más que comprobar cuántas conferencias, artículos y estudios se han realizado sobre este tema recientemente; este interés llegó a su punto álgido el año pasado, pues muchas empresas ven grandes oportunidades y creen que el IdC encierra la promesa de ampliar y mejorar los procesos empresariales y acelerar el crecimiento.

No obstante, la rápida evolución del mercado de IdC ha provocado una explosión en cuanto al número y la variedad de soluciones de IdC, lo que ha creado verdaderos retos a medida que evoluciona la industria, sobre todo la urgente necesidad de asegurar un modelo de fiable que realice tareas comunes como percibir, procesar, almacenar y comunicar. El desarrollo de ese modelo nunca será una tarea fácil, pues hay muchos impedimentos y retos a los que se enfrenta un modelo de Internet de las Cosas realmente fiable.

Una de las funciones críticas de la utilización de soluciones de IdC es aprovechar el análisis de IdC para extraer la información recogida por las “cosas” de diversos modos, por ejemplo entender el comportamiento de los consumidores para ofrecer servicios, mejorar productos e identificar e interceptar momentos de negocio. El IdC exige nuevos enfoques analíticos; a medida que los volúmenes de datos aumenten y lleguen según se prevé en 2021 a niveles astronómicos, las necesidades de los análisis de IdC pueden desviarse aún más de los análisis tradicionales.

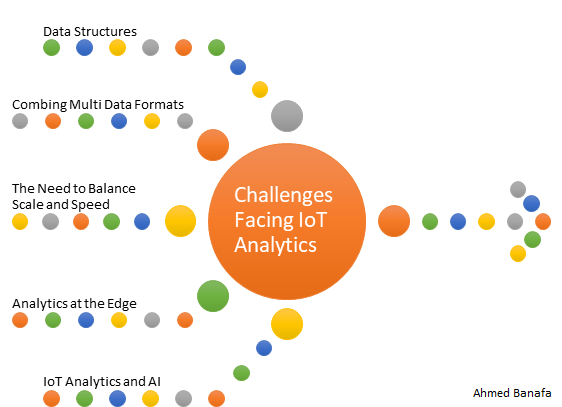

Hay muchos retos a los que tienen que enfrentarse los análisis de IdC, entre otros, las estructuras de datos, la combinación de múltiples formatos de datos, la necesidad de equilibrar magnitud y velocidad, el análisis en la periferia (at the Edge) y el análisis de IdC y la IA.

Estructuras de datos

La mayoría de los sensores envían datos con una marca de tiempo y la mayor parte de los datos es “aburrida”, no sucede nada durante gran parte del tiempo. Sin embargo, de vez en cuando sucede algo serio y tiene que atenderse. Aunque las alertas estáticas basadas en umbrales son un buen punto de partida para analizar estos datos, no pueden ayudarnos a avanzar hacia el diagnóstico o las fases predictivas o prescriptivas. Puede haber relaciones entre los datos recogidos en intervalos de tiempo específicos. En otras palabras, los clásicos retos de las series temporales.

Combinación de múltiples formatos de datos

Aunque los datos de series temporales tienen establecidos procesos y técnicas para su manejo, las percepciones que realmente importarían no pueden venir solo de los datos de los sensores. Normalmente hay fuertes correlaciones entre los datos de los sensores y otros datos no estructurados. Por ejemplo, una serie de códigos de error de la unidad de control podría dar como resultado una acción de servicio específica que registra un mecánico. De igual modo, un conjunto de valores de temperatura puede ir acompañado de un cambio repentino en la forma macroscópica de una pieza que puede captarse mediante una imagen o un cambio en la frecuencia audible de un eje giratorio. Tendríamos que desarrollar técnicas donde los datos estructurados deban combinarse de forma eficaz con los datos no estructurados o lo que llamamos datos oscuros.

La necesidad de equilibrar magnitud y velocidad

La mayor parte de los análisis serios de IdC se producirán en la nube, en un centro de datos o más probablemente en una nube híbrida y un entorno de servidor. Esto se debe a que, a pesar de la elasticidad y escalabilidad de la nube, puede que no sea adecuada para escenarios que requieren el procesamiento de grandes cantidades de datos en tiempo real. Por ejemplo, mover 1 terabyte en una red de 10 Gbps tarda 13 minutos, que está bien para el procesamiento por lotes y la gestión de datos históricos, pero no es práctico para analizar flujos de eventos en tiempo real; un ejemplo reciente son los datos transmitidos por los coches autónomos, especialmente en situaciones críticas que requieren tomar una decisión en milésimas de segundo.

Al mismo tiempo, debido a que distintos aspectos del análisis de IdC pueden necesitar ampliarse unos más que otros, el algoritmo de análisis implementado debe apoyar la flexibilidad, tanto si el algoritmo está implementado en la periferia como si está implementado en el centro de datos o en la nube.

Análisis de IdC en la periferia (at the Edge)

Los sensores, dispositivos y pasarelas de IdC están distribuidos en plantas de producción, hogares, comercios minoristas y campos agrícolas distintos, por nombrar solo unas cuantas ubicaciones. Pero mover un terabyte de datos en una red de banda ancha de 10 Mbps tardará nueve días. De modo que las empresas tienen que planificar cómo tratan el 40% de los datos de IdC previstos que se procesarán en la periferia dentro de pocos años. Esto es especialmente válido para las grandes implementaciones de IdC donde puede que miles de millones de eventos se transfieran cada segundo, pero los sistemas solo tienen que conocer el promedio a lo largo del tiempo o recibir avisos cuando una tendencia esté fuera de los parámetros establecidos.

La respuesta es realizar algunos análisis en los dispositivos o pasarelas de IdC de la periferia y enviar los resultados agregados al sistema central. A través de esos análisis en la periferia, las organizaciones pueden garantizar la oportuna detección de tendencias o aberraciones importantes y reducir a la vez el tráfico de la red de forma considerable para mejorar el rendimiento.

La realización de análisis en la periferia requiere un software ligero, ya que los nodos y pasarelas de IdC son dispositivos de baja potencia con una fuerza limitada para el procesamiento de consultas. Para afrontar este reto, la informática en la niebla es la solución.

La informática en la niebla permite la informática, la toma de decisiones y la adopción de medidas a través de los dispositivos de IdC y solo sube los datos pertinentes a la nube; Cisco ha acuñado el término “informática en la niebla” y ha hecho una definición excelente: “La informática en la niebla extiende la nube para que esté más cerca de las cosas que producen y actúan en los datos de IdC. Estos dispositivos, llamados nodos de niebla, se pueden implementar en cualquier parte con una conexión de red: en una planta de producción, sobre un poste de electricidad, a lo largo de la vía del ferrocarril, en un vehículo o en un pozo de petróleo. Cualquier dispositivo con capacidad informática, de almacenamiento y conectividad de red puede ser un nodo de niebla. Entre los ejemplos se incluyen controladores industriales, interruptores, enrutadores, servidores integrados y cámaras de videovigilancia”. Las principales ventajas de utilizar la informática en la niebla son las siguientes: minimiza la latencia, conserva el ancho de banda de la red y aborda los problemas de seguridad en todos los niveles de la red. Además, funciona correctamente con las decisiones rápidas, recoge y protege una amplia diversidad de datos, transfiere datos al mejor lugar para su procesamiento, reduce los gastos al utilizar una gran potencia de computación solo cuando es necesario y menos ancho de banda y ofrece mejores análisis y percepciones de los datos locales.

Tenga en cuenta que la informática en la niebla no supone la sustitución de la informática en la nube bajo ningún concepto; funciona en combinación con la informática en la nube, optimizando el uso de los recursos disponibles. La informática en la niebla es producto de la necesidad de enfrentarse a muchos retos: el procesamiento y la acción en tiempo real de los datos entrantes y la limitación de recursos como el ancho de banda y la potencia informática; otro factor que ayuda a la informática en la niebla es el hecho de que aprovecha el carácter distribuido de los recursos de TI virtualizados de hoy en día. Esta mejora en la jerarquía de la trayectoria de los datos se debe al aumento de la funcionalidad de computación que los fabricantes están creando en sus enrutadores e interruptores periféricos.

Análisis de Internet de las Cosas e IA

La mayor potencia del análisis de IdC, que aún está en gran medida sin explotar, es poder ir más allá de la reacción a los problemas y a las oportunidades en tiempo real y en su lugar, prepararse para ellos por anticipado. Esa es la razón por la que la predicción es fundamental para muchas estrategias de análisis de IdC, ya sea prever la demanda, anticipar el mantenimiento, detectar fraudes, predecir la producción o segmentar clientes.

La inteligencia artificial (IA) utiliza y mejora los modelos estadísticos actuales para manejar la predicción. La IA aprenderá automáticamente las reglas subyacentes, proporcionando así una atractiva alternativa a los sistemas de solo reglas, que requieren la intervención de profesionales para crear reglas y evaluar su rendimiento. Cuando se aplica la IA, esta proporciona percepciones valiosas y accionables.

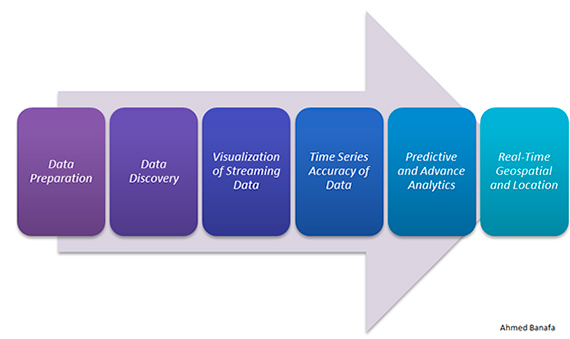

Hay seis tipos de Análisis de datos de IdC en que la IA puede ayudar:

- Preparación de datos: definir grupos de datos y limpiarlos, lo que nos llevará a conceptos como los lagos de datos.

- Descubrimiento de datos: encontrar datos útiles en los grupos de datos definidos.

- Visualización de datos en streaming : tratar de inmediato datos en streaming mediante la definición, descubrimiento y visualización de datos de formas inteligentes para facilitar que el proceso de toma de decisiones tenga lugar sin retrasos.

- Precisión de las series temporales de datos: mantener un nivel de confianza alto en los datos recopilados con una precisión e integridad elevadas de los datos.

- Análisis predictivo y avanzado: paso muy importante en el que se pueden tomar decisiones con base en los datos recopilados, descubiertos y analizados.

- Geoespacial y ubicación en tiempo real (datos logísticos): mantener el flujo de datos tranquilo y bajo control.

Pero no es todo “de color de rosa”, hay retos a los que enfrentarse cuando se utiliza la IA en el IdC: compatibilidad, complejidad, privacidad/seguridad, problemas éticos y jurídicos y estupidez artificial.

Surgirán muchos ecosistemas de IdC y las luchas entre estos ecosistemas dominarán áreas como la casa inteligente, la ciudad inteligente, las finanzas y la atención sanitaria. Pero los verdaderos ganadores serán los ecosistemas con mejores herramientas de análisis de IdC, herramientas más fiables, rápidas e inteligentes; después de todo, lo importante es cómo podemos convertir los datos en percepciones, las percepciones en acciones y las acciones en beneficios.

Ahmed Banafa, Autor de los libros:

Secure and Smart Internet of Things (IoT) Using Blockchain and AI

Blockchain Technology and Applications

Referencias:

- http://www.simafore.com/blog/3-challenges-unique-to-iot-analytics

- https://www.linkedin.com/pulse/why-iot-needs-fog-computing-ahmed-banafa

- http://www.odbms.org/2016/09/five-challenges-to-iot-analytics-success/

- https://www.linkedin.com/pulse/ai-catalyst-iot-ahmed-banafa

- https://www.linkedin.com/pulse/secure-model-iot-blockchain-ahmed-banafa

- http://www.gartner.com/newsroom/id/3221818

Comentarios sobre esta publicación